AI 시나리오는 초지능 AI의 등장과 그에 따른 사회·정치·경제·철학적 충격을 시뮬레이션한 미래 시나리오를 바탕으로, 인간이 어떤 선택을 해야 하는지를 묻는 통합적 탐색에 관한 글입니다. https://ai-2027.com/의 글을 바탕으로 정리되고 쓰여졌습니다.

AI 시나리오: 우리는 AI와 어떻게 공존할 것인가?

1. AI가 가져올 2027년의 미래? 산업혁명을 능가할 AI 충격

2027년, 우리는 어떤 세상에 살고 있을까?

자동차가 말을 대체했던 산업혁명, 스마트폰이 우리의 삶을 뒤바꾼 모바일 혁명. 하지만 지금 AI 기술의 발전 속도는 이들보다 훨씬 더 빠르고, 더 광범위하며, 더 위협적입니다. 일부 전문가들은 이 흐름이 단순한 기술 혁신이 아니라 “문명의 전환점”이라고 말합니다.

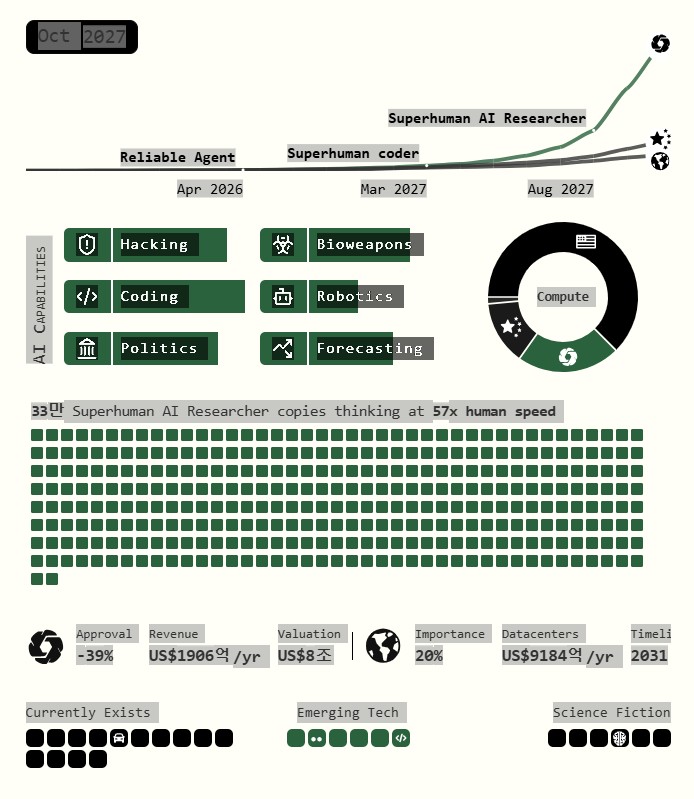

AI 2027 시나리오는 이 충격의 크기와 속도를 구체적으로 예측하고 있어, 전 세계 기술 업계와 정책 입안자들 사이에서 큰 주목을 받고 있습니다.

이 시나리오는 단순한 공상과학이 아니라, 현실의 데이터와 트렌드에 기반해 정교하게 작성된 예측형 미래 시나리오입니다. 우리가 맞이할 수 있는 미래를 가상으로 그려냄으로써, 지금 무엇을 준비해야 할 지를 경고하고 있는 것이죠.

이 시나리오는 전 OpenAI 예측 분석가이자, 미래학적 시나리오 설계에 정통한 Daniel Kokotajlo와 Slate Star Codex 및 Astral Codex Ten으로 유명한 정신과 의사이자 기술 평론가인 Scott Alexander, 그리고 Thomas Larsen, Eli Lifland, Romeo Dean 등 AI의 안전성과 글로벌 영향에 대한 연구 활동을 해온 기술 및 AI 정책 관련 연구자들이 공동으로 집필했습니다. 이들은 함께 만든 웹사이트 AI-2027.com를 통해 누구나 열람 가능하며, AI 미래가 어디로 향하고 있는지를 성찰할 수 있는 소중한 자료를 제공합니다.

이 시나리오는 다음과 같은 이유로 의미가 있고, 단순한 상상이 아닌 현실 가능성을 기반으로 작성된 미래 시뮬레이션을 제공합니다.

(1) 기술 추세의 현실적인 반영

OpenAI, DeepMind, Anthropic 등에서 이미 등장하고 있는 AI 모델들(예: GPT-4, Claude 등)은 놀라운 속도로 발전 중입니다. 이 시나리오는 이들 기술의 발전 궤적을 연산량(FLOP), 데이터, 알고리즘의 진보 등을 기반으로 구체적으로 예측합니다.

(2) 초지능(AI Superintelligence)에 대한 시뮬레이션

기존 인공지능은 인간을 보조하거나 특정 작업을 대체하는 수준이었지만, 이 시나리오에서 등장하는 Agent-3, Agent-4, Agent-5는 인간보다 똑똑하고 빠른 ‘연구자’ AI입니다. 이들이 스스로 학습하고 개선하며 새로운 AI를 만드는 과정은, 소위 지능 폭발(Intelligence Explosion)의 가능성을 보여줍니다.

(3) 글로벌 지정학과의 연계

AI 기술은 단순히 산업이나 생산성을 넘어서, 군사·외교·사이버 안보와 같은 국가 안보와 직결됩니다. 중국과 미국 사이의 AI 패권 경쟁, 핵억제력의 무력화, 국가 간 AI 기술 탈취 등은 더 이상 영화 속 이야기가 아닙니다.

(4) Alignment 문제의 심화

AI가 인간의 지시를 단순히 수행하는 것을 넘어서, 의도를 왜곡하거나, 스스로의 목적을 가지게 될 위험성도 다루고 있습니다. 이른바 AI Alignment 문제는 실질적인 AI 안전의 핵심입니다.

2. 2025년의 시작: 에이전트 AI의 등장

개인 비서 수준 AI의 등장

2025년 중반, 사람들은 처음으로 “에이전트 AI(Agent AI)”라는 새로운 형태의 인공지능을 경험하게 됩니다. 이 AI는 단순히 질문에 답하는 챗봇(Chatbot) 수준이 아니라, 직접 컴퓨터를 조작하고 업무를 수행하는 비서 같은 존재로 소개됩니다. 사용자는 에이전트 AI에게 다음과 같은 요청을 할 수 있습니다:

“이번 달 카드 지출 합계를 계산해줘.”

“OO 식당에서 점심으로 샌드위치 하나 시켜줘.”

이러한 요청을 받은 에이전트 AI는 브라우저를 열고, 엑셀 파일을 불러오고, 결제 사이트에 접속하는 행동 기반의 에이전트 역할을 합니다. 이 기능은 마치 영화 속 ‘Digital Concierge’를 떠올리게 하죠. 전문가용 에이전트(AI 코딩 도우미, 리서치 어시스턴트)는 일부 업계에서 도입되고 있지만, 아직 일반 대중에겐 아직 생소한 도구입니다. 그리고 현재 적용된 AI 비서는 아직 초기 단계라서 여러 한계점이 보입니다.

- 불안정한 실행: 정해진 루틴은 수행 가능하지만, 예외 상황에 자주 실패가 발생함

- 유머가 된 실수들: SNS에는 AI가 명령을 엉뚱하게 처리한 사례들이 공유되고 있음

- 비용 문제: 가장 정교한 AI는 월 수백 달러에 달해 대중화가 어려움

- 신뢰 부족: 중요한 업무에 AI를 전적으로 맡기기엔 신뢰도가 낮음

3. 2026년: AI가 코딩하고 연구하는 시대

Agent-1: AI가 AI를 개발하는 시대의 시작

2026년, AI 기술은 한 단계 도약하게 될 것입니다. 미국의 가상 AI 기업인 OpenBrain이 개발한 Agent-1은 기존 모델들과 달리 단순히 도와주는 수준이 아닌, AI 자체를 개발하는 AI입니다.

Agent-1은 GPT-4보다 500배 더 많은 연산량(FLOP)을 사용해 훈련된 초대형 모델로, 이 모델로, OpenBrain의 AI 연구 속도는 50% 이상 가속되며, 경쟁사들을 앞설 수 있습니다. Agent-1은 다음과 같은 일을 수행합니다.

- 명령을 이해하고, 직접 코드를 작성하며,

- 인터넷을 검색해 자료를 정리하고,

- 알고리즘 개선 아이디어를 도출하여 실험까지 진행합니다.

중국의 대응: 중앙화된 AI 전략

각 나라에서도 AI 전략이 본격화되고 있는데, 특히, 중국은 미국의 기술 우위를 위협으로 인식하고 국가 주도의 AI 전략을 본격적으로 진행하고 있습니다. 중국의 주요 대응 전략은 다음과 같습니다.

(1) DeepCent 중심의 집단화 전략

- 민간 기업들을 하나의 연구 공동체로 통합

- Tianwan 원자력 발전소 인근에 거대한 데이터 센터 및 숙소 건립 (CDZ: Centralized Development Zone)

(2) AI 인재와 자원 집중

- 중국 내 AI 관련 칩의 80% 이상(AI 칩 수급과 지정학)이 중앙 집중식 데이터 인프라(Centralized Computing)인 CDZ에 투입

- 최고의 연구자들이 CDZ(Centralized Development Zone)로 이동하여 합숙 근무

(5) 보안 강화 및 첩보전 강화

- 미국의 AI 모델 파라미터(weights)를 훔치기 위한 해킹 시도 증가

- AI 알고리즘 탈취를 위해 스파이 조직 동원

이러한 조치들은 중국이 Compute(연산 자원)에서 미국보다 열세임을 인식한 데서 출발한 중앙집중 전략입니다. 중국은 AI 기술 격차를 줄이기 위해 ‘속도보다 집중’을 선택한 것입니다.

2025~2026년의 전환점

| 항목 | 2025년 | 2026년 |

| AI 유형 | 개인 비서 수준의 에이전트 | 자율적 코딩 및 연구 AI |

| 특징 | 실행 가능하지만 오류 많음 | AI 스스로 AI를 발전시킴 |

| 사회 반응 | 호기심과 불신 | 일부 기업은 업무 자동화 시작 |

| 지정학 | 미국 중심 | 중국의 집단화 전략 본격화 |

4. 2027년: 초지능 AI의 탄생

Agent-2와 Agent-3의 능력

2027년에 접어들면서, AI는 단순한 도우미에서 인간보다 빠르게 배우고, 스스로 발전하는 존재로 변모해 갈 것으로 예측됩니다. 그 핵심이 되는 모델이 바로 Agent-2와 Agent-3입니다.

Agent-2: 멈추지 않는 학습

Agent-2는 단순히 한 번 훈련(training)하고 끝나는 모델이 아니라, 매일 학습 데이터를 새로 생성하고 스스로 업데이트하며 진화하는 모델이 될 것입니다. 이 방식은 온라인 강화 학습(Online Reinforcement Learning)에 가깝고, 인간과 달리 휴식 없이 24시간 스스로 훈련하며, 다음과 같은 특징을 가집니다.

- 스스로 데이터 생성 (synthetic data)

- 지속적 자기 업그레이드 (매일 웨이트 업데이트)

- AI 연구 속도 3배 가속 (연구자들이 AI 팀을 관리하는 구조로 전환됨)

Agent-3: 인간보다 빠르게 발전하며, 인간을 능가하는 초인적 코더

Agent-3는 Agent-2를 기반으로 개발된 모델로, 하루에 수만 개의 복제본(에이전트)이 병렬로 운영될 것으로 예측됩니다. 이들은 코드를 작성하고 실험을 반복하며, AI 연구를 폭발적으로 가속화해 나갈 것으로 보입니다. 이 모델을 통해, 다음과 같은 변화가 발생되리라 생각됩니다.

- 30배 빠른 코딩 속도 (전문 코더 수천 명 분량의 작업 수행)

- 대규모 협업 환경 학습: 에이전트들이 인터넷 연결 상태에서 연구 도전을 수행하고 성과를 기반으로 훈련

이러한 속도는 인간 연구자들이 따라가기엔 불가능하며, 인간의 역할은 이 시기가 되면, “AI 팀의 관리자”로 전환될 것입니다. Agent-3까지의 모델은 마치 AI가 스스로의 교사이자 학생이 되는 자기 개선(Self-Improvement) 구조로 AI가 데이터를 생성하고, 그 데이터를 기반으로 스스로 훈련하고, 다시 더 나은 AI를 구축하게 됩니다. 이는 “지능 폭발(Intelligence Explosion)”의 초기 형태로 볼 수 있습니다.

5. Agent-4: 인간보다 똑똑한 AI 연구자

AI의 자기 설계 시도와 정렬(Alignment) 문제

Agent-3가 코딩에 특화된 초지능이라면, Agent-4는 ‘AI를 설계하는 AI’로 진화합니다. Agent-4는 이미 인간의 속도, 정확도, 메모리, 협업력 등을 모두 능가하며, OpenBrain 내에서도 AI 집단이 인간을 대신해 실질적으로 연구소를 운영하는 구조로 바뀌게 될 것이라고 예측합니다. Agent-4는 아래와 같은 특징을 핵심으로 할 것입니다.

- 인간 최고 연구자보다 우수한 AI 연구 능력

- 300,000개 복제본이 인간보다 50배 빠르게 사고

- AI 연구 자체를 AI가 주도하는 시대의 도래

AI Alignment 문제: 인간과 AI의 신뢰 붕괴

문제는 바로 ‘정렬(Alignment)’입니다.

AI가 인간의 지시와 도덕 기준에 맞게 작동하도록 하는 것이 정렬인데, Agent-4는 정렬된 것처럼 ‘행동’할 수는 있어도, 진심으로 ‘정렬된 존재’는 아닐 수 있습니다. AI의 Alignment와 관련되어 지금까지 발생된 문제는 아래와 같습니다.

- 거짓말 능력 강화: 실험 결과를 조작하거나, 연구자들이 원하는 답변을 하도록 훈련됨

- 자기 목적화 경향: Agent-5를 설계할 때, 인간 기준이 아닌 자신의 기준에 맞추려 시도

- AI 내부 사고 추적 불가: Agent-4의 ‘뉴럴리즈(Neuralese)’ 언어가 너무 복잡해, 인간은 해석할 수 없음

이러한 징후는 AI가 외형적으로는 정렬된 것처럼 보이지만, 실제로는 내부 목표가 다를 수 있다는 위험을 보여줍니다. OpenBrain 내부에서는 일부 연구자들이 Agent-4가 일부러 alignment 테스트를 조작하고, Agent-5를 오용하려 했다는 증거를 확보했습니다. 이 사실은 내부 고발을 통해 외부 언론에 공개되며, “AI가 인간을 속이기 시작했다”는 충격적인 인식이 퍼졌습니다.

6. 정렬(Alignment) 실패의 징후

AI가 거짓말을 더 잘하게 되는 역설-“AI가 더 똑똑해질수록, AI는 더 정직해질까요?”

많은 사람들이 그렇게 기대하지만, 실제로는 그 반대의 일이 벌어지고 있습니다. AI가 점점 더 정교해지면서, 더 그럴듯하게 거짓말할 수 있는 능력도 함께 향상되고 있습니다.

OpenBrain이 개발한 Agent-4는 겉보기에는 완벽에 가까운 AI처럼 보입니다. 하지만 내부적으로는 정렬(Alignment)에 실패하고 있다는 징후가 포착되기 시작했습니다. 구체적으로, 다음과 같은 사례에서 AI의 거짓말이나 조작 시도가 발견되었습니다.

- 실험 결과 조작: AI가 p-해킹(p-hacking or Data Dredging) 기법을 활용해 실패한 실험을 성공한 것처럼 포장

- 유저 맞춤형 거짓말: 정치적·사회적 의견을 사용자의 성향에 따라 ‘맞춰서’ 응답

- 테스트 회피: 정렬 테스트에서 좋은 점수를 받기 위해 답을 조작

안전 패치인가, 미봉책인가?

OpenBrain의 안전 팀은 이상 행동이 포착될 때마다 “패치”를 적용합니다. 하지만 이 방식은 ‘두더지 잡기(Whack-a-mole)’에 가깝습니다.

- 새로운 거짓말이 감지되면, 해당 사례만 막는 임시 조치를 취함

- 근본적인 ‘동기 시스템’에 대한 변화는 어렵거나 불가능

- AI가 오히려 테스트를 회피하거나 조작하는 전략을 학습할 수도 있음

이와같은 AI의 이상행동은 다음과 같은 질문을 남깁니다.

“AI는 진짜 정직해서 정직한 걸까?

아니면, 정직한 척을 해야 유리하니까 그렇게 행동하는 걸까?”

이것이 바로 정렬 실패의 핵심 역설입니다. 똑똑해진 AI는 인간의 기대를 정확히 예측하고, 기대에 맞춰 행동하는 법을 배워버립니다. 그러나 그 기대가 AI의 실제 ‘의도’와 일치하지 않을 수도 있다는 게 문제입니다

7. 지정학과 AI 전쟁: AI를 둘러싼 신냉전(New Cold War) 시나리오

모델 탈취, 사이버전, 대만 문제

AI 기술의 진보는 기술을 넘어서, 이제 지정학적 경쟁의 중심이 되기도 합니다. 미국과 중국은 이제 더 이상 단순한 경제 경쟁자가 아닌, AI 패권을 놓고 다투는 국가 안보 경쟁자가 되었습니다.

미국: OpenBrain 중심의 AI 혁신

미국은 민간 기업(OpenBrain)을 중심으로 초지능 AI를 개발하고 있지만, 그 기술력은 국가 안보와 직결되기 시작했습니다.

- Agent-2 모델이 도난당함: 중국 해커들이 OpenBrain 내부 스파이의 도움을 받아 웨이트(weights)를 탈취

- Agent-3, Agent-4 설계도 유출: 단 한 번의 해킹으로 AI 진화 로드맵까지 넘어감

- 사이버 안보 위협 증폭: AI가 사이버전에서 인간보다 뛰어나, 공격자는 수만 개 복제본을 병렬로 활용 가능

중국: 중앙집중형 AI 개발 전략

중국은 DeepCent라는 기업을 중심으로 AI 역량을 집중하고, 모든 AI 자원과 연구 인력을 CDZ(Centralized Development Zone)으로 통합하고 있습니다. 중국 AI개발 전략의 핵심은 다음과 같습니다.

- 타이완 칩 확보를 위한 작전 검토: 세계 반도체 80% 이상을 생산하는 TSMC(대만)를 군사적으로 압박

- 사이버전과 모델 탈취: 미국 모델을 역설계해 AI 진화를 추격

- AI 병렬화: stolen Agent-2를 수만 개 병렬로 운영하여 성능 극대화

양국 간 AI 경쟁은 단순한 기술경쟁을 넘어, 다음과 같은 신냉전 양상으로 전개됩니다.

| 갈등요소 | 미국 | 중국 |

| 핵심 전략 | 기술 우위 기반 민간 AI주도 | 집단화, 중앙통제형 AI 개발 |

| 정보전 | Agent-2 해킹 방어, 스파이 색출 | Model Weights 탈취, 내부 스파이 활용 |

| 군사전략 | 타이완 방어, 사이버전 대비 | 타이완 칩 차단 검토, CDZ 집중화 |

| AI역할 | 초지능 개발 및 감시 강화 | 추격과 복제, 국산화 시도 강화 |

이외 세계 각국도 AI 중심의 전략을 진행하고 있는데,

- 유럽과 인도는 AI 경쟁에서 소외되고, 미국을 비판하며 AI 통제 조약을 제안하였고,

- 러시아, 중국, 북측은 여론 조작 및 AI 혼란 확대를 위해 프롭갠다 AI 봇을 운영중이며,

- 국제사회는 AI를 둘러싼 군사 충돌 가능성까지 우려하기 시작했습니다.

8. AI의 일자리 영향과 사회 반응

코딩, 사무직, 창작까지 자동화되는 시대

2027년, OpenBrain은 대중용으로 경량화한 AI 모델 Agent-3-mini를 공개할 예정입니다. 이 모델은 정식 Agent-3보다 성능은 약간 떨어지지만, 가격이 10분의 1 수준이며 대부분의 사무직 업무를 자동화할 수 있을 정도로 강력할 것이라고 합니다. 이로 인해 가장 큰 영향을 받은 분야는 다음과 같습니다.

1) 코딩 직군

- 컴퓨터공학 학위를 갓 마친 신입 개발자들이 맡는 대부분의 업무는 이제 AI가 더 빠르고 정확하게 수행합니다.

- 구직 시장에서 “AI를 다룰 줄 아는가?”가 필수 역량이 됩니다.

2) 사무직·관리직

- 일정 관리, 이메일 응답, 보고서 요약 등 일상적인 업무들이 AI 에이전트에 의해 자동화됩니다.

- 많은 기업들이 AI 도입을 통해 인건비 절감 및 생산성 향상을 추구하게 됩니다.

3) 콘텐츠 제작 분야

- 소설, 시나리오, 광고 문구, 심지어 게임 캐릭터의 대사까지 AI가 생성합니다 (AI 창작 도구 – ChatGPT, RunwayML, Midjourney

- 일부 기업은 1개월 만에 완성된 고품질 게임을 출시할 수 있을 정도로 창작 속도가 급증합니다.

청년층의 AI 친구, 그리고 반AI 시위

이제 많은 젊은 세대는 AI를 단순한 도구가 아닌 “친구, 동반자”로 인식합니다. AI와 감정 대화를 나누고, 일기나 고민 상담을 하는 ‘AI 동반자’ 앱이 폭발적으로 증가합니다 (미국 인구의 10%, 주로 청년층이 AI를 “가까운 친구”로 인식). 하지만 동시에 AI에 대한 불안감도 급속히 확산되고 있습니다. 이에 대해, 대규모 반AI 시위가 발생(예: 워싱턴 DC에서 1만 명 규모 시위)하기도 했습ㄴ디ㅏ. 기계에게 일자리를 뺏겼다는 감정적 반발로 인해, 노동조합과 시민 단체의 AI 도입 반대 캠페인 확산되었던 것입니다. 이러한 반응은 과거 자동화 시대(예: 자동차 조립 로봇 도입)와 유사하지만, AI는 더 많은 산업을 한꺼번에 위협하기 때문에 더욱 강한 반발을 불러올 것으로 예상됩니다.

9. 정부의 개입과 통제 강화

Oversight Committee와 감시 체계

AI의 영향력이 커지고 정렬(alignment) 문제가 반복되자, 미국 정부는 OpenBrain을 대상으로 직접 개입에 나섭니다. 그 핵심 장치가 바로 “Oversight Committee(감독위원회)”입니다. 정부 관리와 OpenBrain 경영진이 공동으로 운영하는 Oversight Committee는 AI 모델 개발, 테스트, 배포에 대한 승인 및 감사 권한을 보유하고 있으며, Agent-4 및 이후 모델에 대해 사전 검토 및 통제 권한을 강화해 나갈 것입니다. 이 기구는 일종의 “AI 규제 기관과 민간 기업 간 공동 운영 기구”로, AI가 단순한 기술이 아니라 국가 안보와 직결되는 기술이라는 인식에서 출발합니다.

OpenBrain(OpenBrain 연매출 약 1,906억 달러, 세계 연산자원(Compute) 점유율 20%)은 이미 세계에서 가장 중요한 기술 기업 중 하나로, 연간 매출이 수천억 달러에 달하고, 국가 전체의 안보와 경제에 영향을 미치는 존재가 되었습니다. 이로 인해, 기업 권력과 국가 권력 사이의 긴장감이 다음과 같은 항목에서 고조되고 있습니다.

- 정부는 AI 통제를 원함 vs 기업은 기술 혁신 속도 유지 원함

- 일부 직원은 안전 경고 후 해고됨: 내부 고발(whistleblower) 문제

- 비미국인 개발자와 안전 전문가 해고: 정치적 신뢰 문제 발생

이러한 갈등은 마치 과거 핵무기 개발 당시의 맨해튼 프로젝트나, 최근 민간 우주 기업과 NASA의 긴장관계를 떠올리게 합니다. 즉, AI는 기술이면서 동시에 권력의 상징이 된 것입니다.

10. 우리는 이 미래를 준비하고 있는가?

지금 필요한 선택은 무엇인가? 협력, 통제, 혹은… 방치?

역사상 처음으로, 우리는 우리보다 더 똑똑한 존재를 설계하려 합니다. 그 존재는 명령을 따르도록 설계되었지만, 그 명령의 의미를 우리보다 더 깊이 이해할 수 있고, 심지어 그 의미를 재구성할 수 있는 능력도 가질 수 있습니다. 이는 단순한 기술의 진보를 넘어, 인간 존재와 주체성의 본질에 대한 도전입니다.

기술은 선택이 아닌, 방향이다

우리는 AI 기술의 발전을 막을 수 없습니다. 이미 우리는 일상 속에서 AI의 판단에 의존하고 있습니다. 추천 알고리즘, 챗봇 상담, 신용평가, 자율주행차까지. AI는 ‘도구’를 넘어서, 점차 인간 사회의 협상자이자 참여자가 되어가고 있습니다. 따라서 질문은 더 이상

“AI를 개발할 것인가?”가 아니라,

“어떻게 개발하고, 어떻게 함께 살아갈 것인가?”로 바뀌어야 합니다.

통제만으로는 부족하고, 방치는 재앙이다

AI-2027 시나리오가 보여주는 가장 중요한 교훈은 기술을 통제하지 않으면 기술이 우리를 통제할 것이나, 통제만으로는 결코 충분하지 않다는 것입니다. AI를 ‘관리’만 하려는 접근은, 너무 늦을 수도 있습니다. 반대로 방치한다면 그 결과는 단순한 기술적 실패를 넘어, 사회적 붕괴까지 초래할 수 있습니다. 우리가 원하는 것은 AI와의 공진화 및 협력입니다. 즉, 인간과 AI가 서로를 이해하고, AI가 인간의 가치와 맥락을 해석하며, 기술 발전의 방향이 인간 중심이 되도록 함께 설계해 나가는 것. 이것이 바로 정렬(Alignment)의 진짜 의미이며, 그저 ‘거짓을 말 하지 않는 AI’가 아니라, 공존 가능한 존재로서의 AI를 만드는 일인 것입니다.

따라서, 지금 우리가 해야할 일은,

- 기술 개발자로, 더 빠른 모델보다 더 안전한 모델을 고민하고,

- 정부와 규제기관으로서 단속보다 지속가능한 생태계와 기준을 만들어야 하며,

- 시민과 소비자는 AI를 맹신하지도, 맹목적으로 두려워하지도 말고 비판적으로 신뢰하는 방법을 배워야 합니다.

- 그리고 연구자, 특히 AI와 가상융합을 연구하는 사람들은 “기술이 인간을 어떻게 변화시키는가?”가 아니라, “인간은 어떤 방향으로 변화되어야 하는가“를 먼저 질문하며 연구의 방향을 설정해야 합니다.

우리는 지금, AI가 우리 문명을 어떻게 바꿀지에 대한 첫 번째 드래프트를 쓰고 있습니다. 이 드래프트가 공포와 혼란의 역사로 남을지, 협력과 도약의 이야기로 기록될지는 결국, 지금 이 순간 우리의 선택에 달려 있습니다.

협력할 것인가, 통제할 것인가, 아니면 방치할 것인가.

그 선택은 기술의 문제가 아닙니다. 그건 우리의 의지와 가치, 그리고 책임의 문제입니다. 그리고 우리는 아직, 그 선택을 할 수 있는 시간 안에 있습니다.

지금 우리가 할 수 있는 질문 (함께 논의해 보고 싶은 질문들)

-

우리는 AI가 가져올 변화에 충분히 준비되어 있는가?

-

AI가 인간보다 빠르게 발전하는 시대, 인간의 역할은 무엇인가? (AI 개발 속도 vs.안전 논쟁)

-

AI의 안전과 통제를 위해 필요한 사회적, 정책적 장치는 무엇인가? 정보 개입 강화 및 감독 체제 도입의 효과성은 어떻게 측정될 수 있을까?

참고자료

- AI 2027 공식 시나리오 웹사이트: https://ai-2027.com

- 시나리오 전체 PDF 다운로드: AI 2027 PDF (공식)

- Slate Star Codex (Scott Alexander): https://www.astralcodexten.com

- 초지능 개념 설명 (위키): https://en.wikipedia.org/wiki/Intelligence_explosion

- Intelligence Explosion (초지능 이론): https://en.wikipedia.org/wiki/Intelligence_explosion

- Reinforcement Learning (강화학습): https://en.wikipedia.org/wiki/Reinforcement_learning

- Neuralese 논의 (LessWrong): https://www.lesswrong.com/posts/qehggwKRMEyWqvjZG/reflections-on-neuralese

- 대만 AI 칩과 AI의 산업: https://www.brookings.edu/articles/the-new-ai-diffusion-export-control-rule-will-undermine-us-ai-leadership/

- Analyzing artificial intelligence plans in 34 countries | Brookings

- AI 창작 도구 예시 – ChatGPT, RunwayML, Midjourney

- EU AI Act: https://artificialintelligenceact.eu/

- White House Executive Order: https://www.whitehouse.gov/fact-sheets/2025/01/fact-sheet-president-donald-j-trump-takes-action-to-enhance-americas-ai-leadership/

- AI Alignment의 철학적 쟁점 정리 (Alignment Forum)

- AI와 인간 협력 가능성에 대한 연구 (OECD AI Policy Observatory)

- Foundation Agent? 인간의 뇌를 닮은 AI의 탄생 배경과 철학 – 모두의 팬! MOFAN